Desde tiempos ancestrales el hombre ha tratado de buscar algún tipo de estrategia o artilugio para intentar detectar la mentira. En la antigua China, por ejemplo, al sospecho le hacían masticar polvos de arroz para luego escupirlo. Como el estrés provoca sequedad de boca, si el arroz estaba seco quedaba probado que el sospechoso había mentido. Afortunadamente la evolución de la humanidad ha ido dejando muy atrás este tipo de “técnicas” para ir caminando hacia otras, más apoyadas en la ciencia y en las nuevas tecnologías. Así, a principios del siglo XIX comenzó a emplearse el polígrafo pero, con posterioridad, fueron apareciendo otras tecnologías como los analizadores de estrés vocal, los sistemas de seguimiento ocular (eye-tracking), la termografía facial, la resonancia magnética funcional (fMRI) o la electroencefalografía (EEG). De todas ellas, en países como Estados Unidos, las dos últimas han adquirido una especial relevancia, potenciándose las investigaciones de éstas con la pretensión de poder contrarrestar las amenazas a la Seguridad, detectando potenciales terroristas o espías. En España, se han comenzado a dar los primeros pasos en el uso de la prueba del potencial evocado P300, aunque exclusivamente con fines forenses. Su uso debe llevarse a cabo siguiendo unos protocolos y apoyándonos en técnicas como el Test de Conocimiento Culpable (GKT) o el Test de Acciones Culpables (GAT).

La detección de mentiras es una actividad compleja que se ve influenciada por múltiples variables como el sexo, la edad o la experiencia de la persona que trata de detectar mentiras. Diversos estudios han puesto de manifiesto que el éxito en reconocer el engaño es similar al que se produce al azar (DePaulo, Kashy, Kirkendol, Wyer, & Epstein, 1996). Otros hallazgos, incluso, muestran que ese porcentaje del 50% se cumple tanto para personas no entrenadas como para la gran mayoría de los profesionales que se dedican al tema de la detección del engaño (DePaulo, y otros, 2003). Por tanto, se ha visto que la capacidad de detección del engaño por parte de los profesionales de la policía se acerca a los porcentajes del azar, aunque diversos programas de entrenamiento y la experiencia parecen contribuir a que esos porcentajes aumenten.

En vista de que la habilidad para detectar mentiras es una tarea compleja, también se han llevado a cabo estudios que trataban de valorar hasta qué punto esa capacidad está influenciada por factores del procesamiento cognitivo. Así surgieron los modelos cognitivos centrados fundamentalmente en el análisis de contenidos (Richard, Boals, & Drogin, 2011), o bien en la carga cognitiva o esfuerzo cognitivo realizado por alguien que está mintiendo. Los argumentos de este último enfoque van en la línea de que mentir requiere un mayor número de recursos cognitivos que decir la verdad y en que se incrementan las posibilidades de cometer errores cuando se provoca esa carga cognitiva (Zuckerman, DePaulo, & Rosenthal, 1981).

En definitiva, a lo largo de los años se han llevado a cabo investigaciones sobre detección de mentiras analizando gran diversidad de modalidades, como la expresión facial, gestos, tono de voz, los contenidos de los mensajes que emite el sujeto, etc. Sin embargo, todavía no se ha llegado a concretar qué modalidad puede proporcionar las mejores claves para detectar el engaño. En vista de esta problemática, y en paralelo también, a lo largo de los años se ha hecho uso de ciertas tecnologías que contribuyeran a arrojar luz a ese complicado mundo de la detección de mentiras. El polígrafo, los analizadores de estrés vocal, las tecnologías de seguimiento ocular o la termografía facial, son solo algunos ejemplos.

Tras los atentados terroristas a las Torres Gemelas (11 de septiembre de 2001), el Gobierno de los Estados Unidos y diversos científicos, coincidieron en la necesidad de tratar de detectar con mayor precisión y rapidez las diferentes amenazas a la seguridad nacional que se les planteaban. Así, se vieron impulsadas diversas tecnologías desarrolladas en los años 90, debido a que supuestamente permitían “desvelar” lo que pasaba por el cerebro de los terroristas sospechosos. En concreto, la resonancia magnética funcional (fMRI) y la electroencefalografía (EEG), basada en la tecnología de huellas digitales del cerebro, comenzaron a tener un gran auge en Estados Unidos de América, llegando a ser consideradas como las mejores tecnologías de detección de mentiras (Littlenfield, 2009).

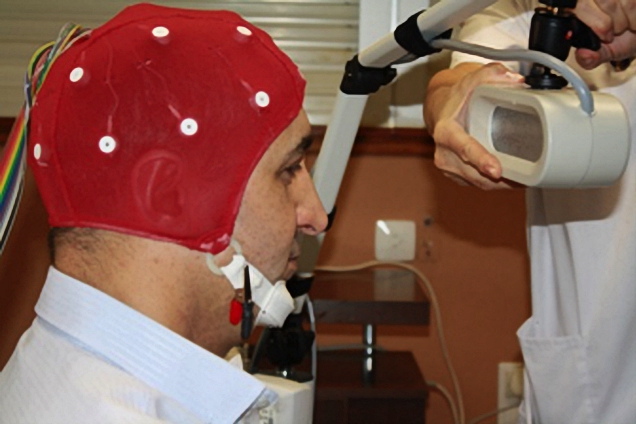

Distintos estudios pusieron de manifiesto que los resultados obtenidos por estas nuevas técnicas eran mucho mejores que los obtenidos por el tradicional polígrafo. El polígrafo, como sabemos, mide los cambios que se producen en el sistema nervioso autónomo ante las diversas preguntas planteadas (concretamente en la respiración, actividad electrodermal, presión arterial y ritmo cardiaco). En cambio la técnica basada en resonancia magnética funcional (fMRI) mide reacciones cognitivas, es decir, trata de detectar la mentira a través de la medición de la actividad de determinadas estructuras y áreas del cerebro. Por su parte, la prueba del potencial P300 también se centra en el cerebro; pero en este caso, en la medida de ondas cerebrales. Por tanto, estas dos técnicas se basan en medidas directas del procesamiento cognitivo y no en medidas dereacciones emocionales, lo que aumenta la objetividad de las mismas.

En España, desde diciembre de 2013, se ha hecho uso de la prueba del potencial evocado P300 en varias ocasiones para tratar de clarificar desapariciones, o ayudar a localizar los restos mortales de víctimas de secuestros y asesinatos [1].

LA POLÉMICA PRUEBA DEL POTENCIAL EVOCADO P300

La utilización por primera vez de la prueba de la P300 no ha estado libre de polémica. No obstante, no entraremos en valoraciones sobre los aspectos legales, sociales y éticos de su empleo, ya que lo que nos interesa es analizar lo que la ciencia ha puesto de manifiesto respecto a la precisión de esta prueba y a su utilidad. En definitiva, nos centraremos en la polémica sobre su validez científica para detectar terroristas o espías, algo que autores como Mixner y Rosenfeld sugirieron en uno de sus artículos, tras aplicar esta prueba a una serie de sujetos que secretamente planearon un simulacro de ataque terrorista en una ciudad importante (Mixner & Rosenfeld, 2010). Aplicando diversos protocolos (Test de Conocimiento Culpable, Protocolo del Ensayo Complejo y utilización de un restringido conocimiento a priori de los detalles del crimen por parte de los sujetos), estos autores, llegaron a identificar a 12 de 12 sujetos culpables y a confirmar algunos detalles del delito (ubicación, método y fecha del ataque terrorista planeado) en 10 de los 12 casos y en 20 de 30 casos.

La repercusión que tuvo dicho artículo llevó a determinada prensa a afirmar que esta herramienta permitía “entrar” en la mente de un terrorista y llegar a saber cómo, cuándo y dónde se produciría un posible atentado[2].

Fiabilidad e inconvenientes de la prueba P300

A la hora de aplicar la técnica de la P300 ocurre que no existe un protocolo consensuado y, por otra parte, sigue sin haber unanimidad sobre su índice de fiabilidad. De esta manera encontramos que los resultados obtenidos en diversas investigaciones varían enormemente en fiabilidad dependiendo del análisis utilizado: Lauwrance Farwell (Farwell & Donchin, 1991) habla de tasas de detección de culpables próximas al 90% (quien curiosamente posee un método patentado para su uso comercial, el conocido Brain fingerprinting), Rosenfeld (Rosenfeld, Soskins, Bosh, & Ryan, 2004) del orden del 82% (uno de los primeros occidentales en publicar investigaciones sobre la P300 en el año 2002) y otros investigadores como Mertens (Mertens & Allen, 2008) hablan de porcentajes del orden del 47% (lo que estaría por debajo del nivel de azar).

Por si fuera poco, esas tasas de fiabilidad disminuyen si, durante la realización de la prueba, el sujeto lleva a cabo algún tipo de contramedida. Además es imprescindible que el individuo preste atención a los estímulos presentados para que su cerebro responda a los mismos; si no les presta atención la onda P300 no aparece. Otro problema añadido es la aparición de falsos positivos (considerar a alguien culpable siendo inocente), ya que recordemos que esta prueba da resultados positivos ante estímulos significativos para el sujeto, pero también ante estímulosnovedosos. Por ello, la selección de estímulos adecuados es fundamental. También puede ocurrir que, según las preguntas planteadas y la información facilitada momentos previos al interrogatorio, se induzcan falsas memorias al sujeto[3]. Por otra parte, es difícil tener garantías de que la información incluida en los estímulos de sondeo (los que contienen información relevante) solo sea conocida por el culpable. Todos sabemos que hoy en día internet, la prensa y la televisión ofrecen tal cantidad detalles sobre cualquier suceso que en muchas ocasiones perjudican cualquier investigación. Por último, esta prueba presenta el gran inconveniente de que cuanto más tiempo transcurra entre el evento y la prueba, la fiabilidad de la misma disminuye (Polich, 2007).

Por tanto, vemos que a esta técnica, como método de alta precisión para detectar mentiras y verificar la verdad, le queda todavía un largo camino que recorrer.

En resumen

El fracaso de los métodos tradicionales para detectar mentiras, ha conducido a que diversos gobiernos, científicos y empresas se centren en la aplicación de los últimos avances de la neurociencia con fines de defensa.

No existe unanimidad a la hora de especificar la fiabilidad de las nuevas tecnologías en detección del engaño, ni tampoco un protocolo consensuado. No obstante, si se utilizan en combinación con otras pruebas, la tasa de precisión puede aumentar.

En el caso de la “prueba de la P300”, la tasa de precisión aumenta cuando se hace uso junto al protocolo GKT (Guilty Knowlwdge Test) o Test de Conocimiento Culpable (también denominada Prueba de Información Oculta o CIT: Concealed Information Test).

En algunos casos interesa sustituir el interrogatorio GKT estándar, que pregunta por el conocimiento de un hecho, por una versión propuesta por Bradley y sus colaboradores (Bradley & Rettinger, 1992). En esta modificación, GAT (Guilty Actions Test), las preguntas que se le hacen al sujeto son sobre acciones supuestamente cometidas por él.

El éxito de la prueba depende en gran medida del acceso que tenga el investigador a los detalles del crimen que no hayan sido divulgados al público o al sujeto sospechoso. Por ello, es fundamental la formación del personal encargado de diseñar la prueba.

El uso de esta tecnología, como método de alta precisión para la detección del engaño en el mundo real, no parece aún conveniente.

En España se han dado los primeros pasos en su utilización con fines forenses, y afortunadamente su aplicación no ha sido para determinar si alguien es culpable o inocente. En futuros casos, su empleo no va a arrojar certeza absoluta pero podrá ser de utilidad para dar pistas y permitir descartes.

Dada la complejidad de su uso para fines de detección de engaño, aunque en casi todos los hospitales de España existan equipos que puedan analizar los resultados de un EEG, ello no garantiza que estos equipos estén cualificados para realizar la prueba con tales fines.

Los resultados de investigaciones como las de Mixner y Rosenfeld (Mixner & Rosenfeld, 2010), simulando situaciones para la detección de terroristas, son esperanzadores, pero recordemos que son estudios de laboratorio y que las circunstancias del mundo real difieren de las condiciones ideales del laboratorio.

Por último, el que la fiabilidad de esta prueba según Farwell (Farwell & Donchin, 1991) alcance prácticamente el 90% (dato que correlaciona con el dinero que está generando la patente de su método), tampoco es garantía para su empleo con la pretensión de detectar potenciales espías o terroristas. En el caso de pretender emplear esta herramienta para tales fines, los niveles de precisión tendrían que ser aún más altos, ya que cuando se trata de emplear esta técnica para intentar detectar un número pequeño de sujetos en una muestra grande, la precisión de la misma debe ser casi perfecta. Si ello no es así, se corre el grave peligro de considerar culpables a un gran número de individuos siendo estos inocentes (no detectará al 10% de culpables, pero si por dicha prueba solo pasaran inocentes, el 10% de los inocentes serían considerados culpables).

No obstante, las nuevas tecnologías, aunque hasta la fecha no han podido dar respuesta a muchas preguntas, sí han permitido mejorar las metodologías y herramientas de detección de mentiras de que disponíamos.

Fuente: Blog de criminología